논문 요약

CNN의 depth는 image super-resolution에서 중요한 요소이다. 하지만 깊은 네트워크일수록 훈련이 어렵다. 저해상도 입력과 features는 풍부한 low-frequency 정보를 가지고 있으며 채널별로 동일하게 다뤄진다. 하지만 이는 CNN의 표현 능력을 방해한다. 이를 해결하기 위해 very deep residual channel attention networks (RCAN)이 제시되었다. Residual in residual (RIR) 구조를 통해 깊은 네트워크를 만들 수 있으며 저해상도 정보가 여러 skip connections들을 통해 지나갈 수 있게 해 메인 네트워크가 고주파 요소들에 집중할 수 있게 한다. 추가로 channel attention을 사용하여 적응형으로 channel-wise features를 재조정한다.

1. Paper Bibliography

논문 제목

Image super-resolution using very deep residual channel attention networks

저자

Zhang et al.

출판 정보 / 학술대회 발표 정보

Proceedings of the European conference on computer vision (ECCV). 2018.

2. Problems & Motivations

1. Depth of representation은 image SR에서 매우 중요한 요소이다. 하지만 단순히 레지듀얼 블록을 많이 쌓아서 깊은 네트워크를 만드는 것은 성능 향상을 기대할 수 없다

2. 대부분의 네트워크는 channel-wise features를 동일하게 취급하여 다른 종류의 정보들( e.g. low-, high-frequency information)에 유연하게 대처할 수 없다. Image SR은 high-frequency정보를 가능한 잘 복원하는 것이 목적이다. 보통 LR이미지는 대부분 low-frequency 정보들로 이루어져 있고 이는 바로 HR output으로 보낼 수 있으며 큰 계산이 필요하지 않다. 또 대부분의 CNN기반 방법들은 원본 LR에서 features를 추출해 chennl-wise관점에서 동일하게 다루었는데 이는 low-frequency에 대해 불필요한 계산을 유발하고 깊은 네트워크에서 얻을 수 있는 표현력을 제한한다.

3. Method

3.1 Flow Estimation Module

RCAN은 크게 4파트로 구성되어 있다: shallow feature extraction, residual in residual (RIR) deep feature extraction, upscale module, reconstruction part

1. 먼저 하나의 conv layer를 통해 LR에서 shallow features를 추출한다

2. Residual Group (RG)로 구성된 deep residual in residual structure을 통해 deep features를 추출한다.

3. 업스케일한다.

4. 마지막으로 하나의 conv layer을 통해 재건된다

RCAN은 L1 loss를 사용했다.

3.2 Residual in Residual (RIR)

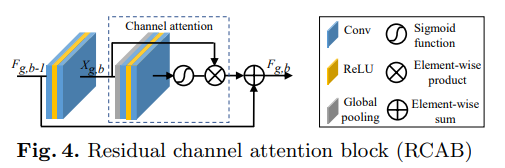

RIR 구조는 G residual groups (RG)와 long skip connection (LSC)로 구성되어 있다. 각 RG는 B residual channel attention blocks (RCAB)와 short skip connection (SSC)로 구성되어 있다.

단순히 RG를 많이 쌓기만 해서는 더 나은 성능을 내기 힘들다. 이를 해결하기 위해서는 long skip connection (LSC)를 사용하여 네트워크를 안정화시켰다. LSC는 정보의 흐름을 쉽게하며 coarse한 level에서 residual 정보를 얻는 것을 가능하게 한다. 각 RG는 B residual channel attention blocks로 구성되어 있다. 메인 네트워크가 더 중요한 정보 features에 집중할 수 있도록 short skip connections (SSC)가 사용되었다. LSC와 SSC를 통해 풍부한 low-frequency 정보는 쉽게 전달이 된다.

3.3 Channel Attention

네트워크가 더 중요한 features에 집중하기 위한 channel attention (CA) 메커니즘을 사용한다. 각 채널마다 다른 attention을 주기 위해 고려할 것은 2가지가 있다

1) LR space는 풍부한 low-frequency 정보를 가지고 있고 귀한 high-frequency 요소도 가지고 있다:

2) Conv의 각 필터는 로컬한 receptive field에서 연산을 한다

과정

1) $X = [x_1, ..., x_c, ..., x_C]$를 입력으로 받는다.

2) channel-wise statistick $z$는 이를 $1 \times 1 \times C \times$로 바꿔 얻을 수 있다. 이 때 $H_{GP}$는 global pooling function이다. 이러한 chnnel statistic은 local descriptors의 collection이라 볼 수 있으며 전체 이미지 표현에 도움을 준다.

$$z_c = H_{GP}(x_c)$$

3) Gating mechanism은 채널간 nonlinear interactions와 non-mutually-exclusive relationship을 학습할 수 있어야 한다. 이때 sigmoid function을 사용했다

$$s = f(W_Uδ(W_Dz))$$

f와 δ는 각각 sigmoid와 ReLU이다. $W_D$는 Conv layer의 weight set이며 reduction ratio $r$만큼의 channel-downscaling을 수행한다. 그 다음 $r$만큼 channel0upscaling을 하며 이때 사용되는 weight set은 $W_U$이다.

4) 마지막으로 최종 channel statistics $s$를 얻을 수 있으며 이는 입력 x_c를 rescale하는데 사용된다

$$\hat{x_c} = s_c \cdot x_c$$

$s_c$는 scaling factor이며 $x_c$는 c-th channel의 feature map이다

Channel attention을 통해 RCAB의 residual component는 적응형으로 recaled된다

3.4 Residual Channel Attention Block (RCAB)

저자는 CA를 RB에 넣은 residual channel attention block (RCAB)를 제시하였다.

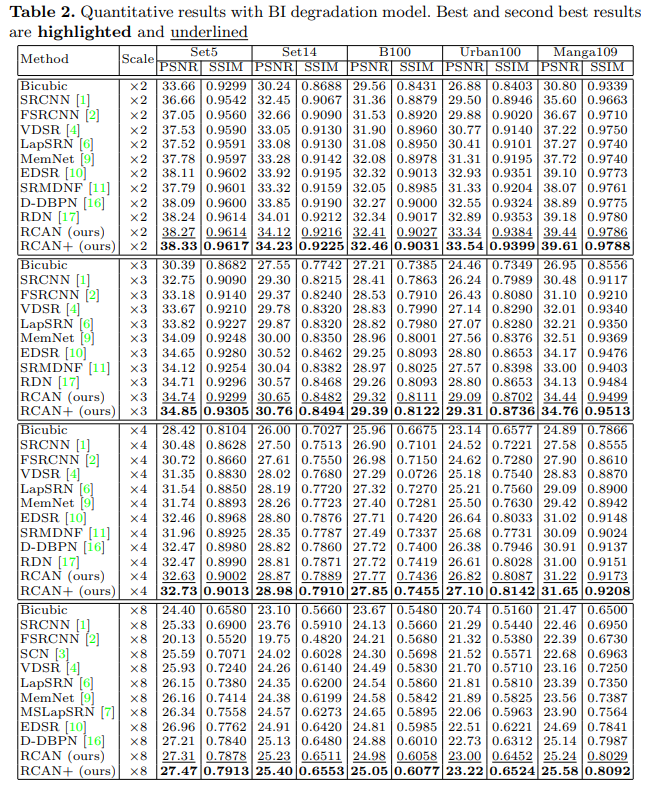

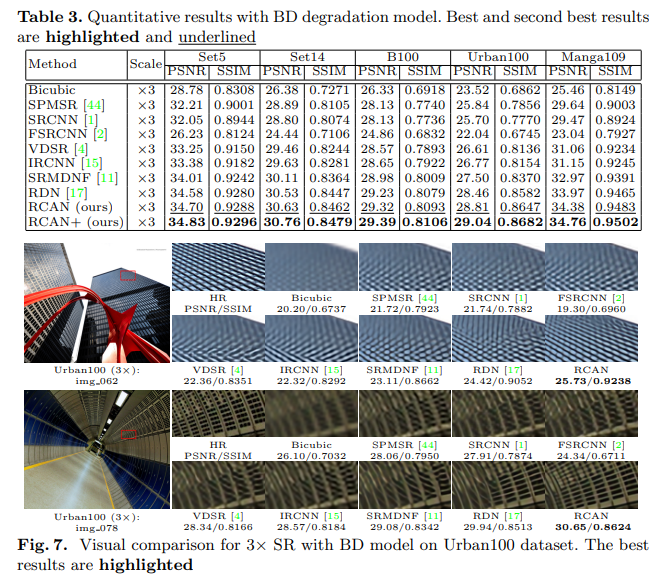

4. Experiments

Datasets

train

- 800 training images from DIV2K dataset

- LR patch size: 48 x 48

test

- Set5, Set14, B100, Urban100, Manga109

Results

Google Scholar Link

Google 학술 검색

Convolutional neural network (CNN) depth is of crucial importance for image super- resolution (SR). However, we observe that deeper networks for image SR are more difficult to train. The low-resolution (LR) inputs and features contain abundant low-frequenc

scholar.google.co.kr

GitHub

https://github.com/yulunzhang/RCAN

GitHub - yulunzhang/RCAN: PyTorch code for our ECCV 2018 paper "Image Super-Resolution Using Very Deep Residual Channel Attentio

PyTorch code for our ECCV 2018 paper "Image Super-Resolution Using Very Deep Residual Channel Attention Networks" - GitHub - yulunzhang/RCAN: PyTorch code for our ECCV 2018 paper "I...

github.com

'논문 리뷰 > Super-Resolution' 카테고리의 다른 글

| [TDAN] Tdan: Temporally-deformable alignment network for video super-resolution (0) | 2022.09.14 |

|---|---|

| [ABPN] Image Super-Resolution via Attention based Back Projection Networks (0) | 2022.08.09 |

| [DRLN] Densely Residual Laplacian Super-Resolution (0) | 2022.08.09 |

| [TOFlow] Video Enhancement with Task-Oriented Flow (0) | 2022.07.18 |

| [RTA] Revisiting Temporal Alignment for Video Restoration (0) | 2022.07.11 |

댓글